2.1 Un poco de historia (I)

§1 Los comienzos

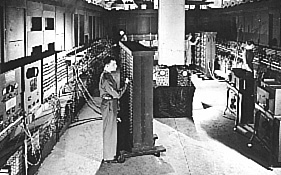

Los ordenadores nacieron grandes, desgarbados, delicados, caros, difíciles de manejar y poco eficientes. De hecho,

el propio ENIAC (![]() Nota-2), al que hemos hecho referencia, era un buen ejemplo. Pesaba

cerca de 30 toneladas y ocupaba el espacio equivalente a una sala de baile; su

operación requería la nada despreciable cantidad de 174.000 W de potencia [0].

Nota-2), al que hemos hecho referencia, era un buen ejemplo. Pesaba

cerca de 30 toneladas y ocupaba el espacio equivalente a una sala de baile; su

operación requería la nada despreciable cantidad de 174.000 W de potencia [0].

|

ENIAC en 1946 |

Su costo era astronómico para la época, de forma que solo algunas instituciones, en este caso la universidad de Pensilvania, con ayuda del Departamento de Defensa, podían permitirse tales "juguetes". A pesar de ello, pronto le siguieron otros. Si bien parece ser que el EDVAC ("Electronic Discrete Variable Automatic Computer"), al que se hace referencia en un famoso artículo de Von Neumann [2] aparecido en 1945: "First draft of a Report on EDVAC", solo existió como una propuesta de diseño, nunca realmente. Sin embrago, el Ferranti Mark I basado en un diseño de F.C. Williams y T. Kilburn de la Universidad de Manchester fue el primer ordenador de uso general que se puso a la venta.

El EDSAC ("Electronic Delay Storage Automatic Calculator"), desarrollado por Maurice Wilkes de Cambridge, fue operativo por primera vez en Junio de 1.949, siendo el inspirador del primer ordenador específicamente construido para aplicaciones de "gestión", el LEO ("Lons Electronic Office").

Por parte americana siguieron el Whirlwind I y el IBM 701. En 1.952 se construyeron dos ordenadores idénticos en la Universidad de Illinois: uno de ellos, el ORDVAC ("Ordinance Variable Automatic Computer"), fue destinado al Laboratorio de Investigaciones Balísticas de Aberdeen, un campo de pruebas del ejército. El otro, ILLIAC, fue retenido en la propia universidad. En 1.949 Eckert y Mauchly, los creadores de ENIAC, ponen en funcionamiento otra criatura: BINAC ("Binary Automatic Calculator"). SEAC, MANIAC, GENIAC, BRANIAC, UNIVAC fueron otros tantos nombres. Como puede verse, toda una constelación de incipientes ACs (Automatic Calculator). En 1951 aparecieron los primeros ordenadores comercialmente accesibles para las empresas que pudieran costeárselos [3].

§2 Una nueva profesión

Los nuevos ingenios se instalaban en edificios y locales con aire filtrado y acondicionado (especialmente los discos eran muy sensibles a los cambios de temperatura), y atendidos por personal específico (durante muchos años el ordenador era el que disponía de mejor, a veces único, sistema de aire acondicionado en empresas e instituciones). De esta época viene la imagen de los operadores de ordenador en sus salas acristaladas (las "casas de cristal") provistos de batas blancas como sacerdotes de una nueva religión.

El coste de explotación era muy alto, por lo que su uso era muy restringido y selectivo (algo así como hoy día puede ser la utilización de un radiotelescopio astronómico). Los usuarios no tenían por lo general acceso directo al ordenador. Los trabajos y programas se preparaban off-line [4], generalmente en formas de fichas y bandas perforadas, que eran entregadas al personal de operación, el cual se encargaba de cargarlo en el ordenador y devolver los resultados, generalmente en forma de listados. Podemos hacernos una idea de la situación considerando que el Honeywell 516 de la Universidad de Utah (uno de los 4 equipos que formaron la primera Internet), tenía 12 KB. de memoria de acceso aleatorio RAM ("Random Access Memory").

Naturalmente había que hacer trabajar al ordenador el mayor tiempo posible (además eran bastante lentos), por lo que los trabajos esperaban en cola ("queue") para ser procesados ("Batch processing" [5] ). Esta técnica de proceso, de "Colas Batch", se sigue utilizando ampliamente en los grandes centros de cálculo con los súperordenadores, cuya operación hay que optimizar. Las tareas y los datos se cargan y aguardan en cola hasta que el ordenador puede ir "digiriendo" cada trabajo (lote) y devolviendo los resultados.

§3 Primeras conexiones

El contacto físico de los usuarios con los ordenadores era bastante escaso, por lo que empezaron a arbitrarse soluciones para acercarlos (siguiera parcialmente). Empezó así el embrión de lo que sería el teleproceso y las Redes, al empezar a utilizar algunos dispositivos físicamente alejados de los ordenadores de los que dependían, enlazados mediante líneas de muy diverso tipo.

Uno de tales proto-servicios fue la impresión en remoto, donde el ordenador

enviaba los resultados a equipos de impresión en las oficinas y despachos de los usuarios. Pronto apareció un

antecesor de TELNET (![]() 8.7), un servicio que permitía ya el acceso a los ordenadores mediante terminales remotos.

Cuando el parque de Computadoras en Universidades y centros de

investigación fue creciendo, se hizo evidente la necesidad de enviar datos

(ficheros) directamente de una computadora a otra, con lo que nació FT

("File Transfer"); un sistema para que una computadora entendiera lo

que enviaba otra, salvando las posibles diferencias particulares (modelo,

lenguaje, formato interno de los ficheros, etc.) A estas alturas, no existía Internet tal como hoy lo concebimos,

solo unas redes interconectando algunos ordenadores. Además, los ordenadores que formaban estas redes eran un mundo

súper restringido que se limitaba como queda dicho a unas cuantas universidades y

centros de investigación del Gobierno USA.

8.7), un servicio que permitía ya el acceso a los ordenadores mediante terminales remotos.

Cuando el parque de Computadoras en Universidades y centros de

investigación fue creciendo, se hizo evidente la necesidad de enviar datos

(ficheros) directamente de una computadora a otra, con lo que nació FT

("File Transfer"); un sistema para que una computadora entendiera lo

que enviaba otra, salvando las posibles diferencias particulares (modelo,

lenguaje, formato interno de los ficheros, etc.) A estas alturas, no existía Internet tal como hoy lo concebimos,

solo unas redes interconectando algunos ordenadores. Además, los ordenadores que formaban estas redes eran un mundo

súper restringido que se limitaba como queda dicho a unas cuantas universidades y

centros de investigación del Gobierno USA.

§4 Primeras redes

Diciembre de 1957 marca otro hito importante en el desarrollo de la informática (en especial de Internet), cuando en plena Guerra Fría, en respuesta al primer satélite soviético, el Departamento de Defensa (DoD) funda la ya mítica ARPA [6]. Agencia de Proyectos Avanzados de Investigación (Advanced Research Proyects Agency), para devolver a los EEUU la superioridad en el área de las aplicaciones militares de la informática. Esta agencia sería el promotor y mecenas de muchos proyectos científicos (no solo informáticos) de gran trascendencia [7], entre otros el lanzamiento del primer satélite artificial USA.

Durante los años 60 y 70 se crearon muchas tecnologías de redes, cada una basada en un diseño específico de hardware. Algunas de estas redes, llamadas de aérea local LAN (Local Aérea Network), conectan equipos en distancias cortas (normalmente dentro del propio Campus de la Universidad), mediante cables y hardware específico instalado en cada equipo. Otras redes más grandes, llamadas de aérea extensa, WAN (Wide Aérea Network), conectaban equipos a distancias mayores utilizando líneas de transmisión similares a las empleadas en los sistemas telefónicos.

A pesar de que las LAN y WAN hicieron que compartir información entre organizaciones fuera mucho más sencillo, la información no podía ser transferida mas allá de los límites de cada red. Cada tecnología de red transmitía la información de modo diferente, supeditada al diseño del propio hardware. Una determinada tecnología LAN solo podía funcionar en ciertos equipos, y la mayoría de las tecnologías LAN y WAN o eran incompatibles entre sí, o la comunicación entre ellas era súmamente complicada.

Con objeto de mejorar las capacidades de transmisión de las líneas telefónicas se ideó la multiplexación. Esta nueva tecnología es ni más ni menos que meter dos o más mensajes distintos (podían ser incluso a destinos distintos) por una misma línea telefónica. Para conseguirlo, los mensajes originales se fraccionan en trozos cortos, y el tiempo de transmisión se divide igualmente en trozos, asignándose sucesivamente un intervalo de tiempo a cada trozo de un mensaje distinto. Un proceso inverso (desmultiplexación) es capaz de reconstruir en la llegada los mensajes a partir de los trozos de cada uno, que van llegando sucesiva y alternativamente [8].

En 1959 en plena guerra fría, los soviéticos lanzan con éxito su primer satélite artificial Sputnik, lo que induce a Norteamérica a redoblar sus esfuerzos científicos y técnicos por conseguir la supremacía tecnológico-militar.

En 1960 el Departamento de Defensa ya poseía una red de computadoras uniendo sus centros estratégicos y de investigación (message-communication network, AUTODIN), aunque tenía conocidas deficiencias. En esta época, en la mitad de la Guerra Fría [9], el DoD se planteó si en caso de que un hipotético ataque nuclear quedara dañara la red de ordenadores, ¿Cómo seguiría comunicando el ejército americano con sus centros de misiles para una réplica?.

Nota: Esta versión, que ha circulado durante algún tiempo, es la versión

"romántica"; aparentemente la realidad no fue exactamente así,

pero desde luego la guerra fría influyó grandemente en todos los desarrollos

relacionados con la defensa, e Internet fue en su origen un proyecto ligado al

DoD. En la nota adjunta (![]() Nota-4),

incluimos algunas opiniones autorizadas al respecto. En la Nota-5

(

Nota-4),

incluimos algunas opiniones autorizadas al respecto. En la Nota-5

(![]() Nota-5), un

interesantísimo artículo del propio Vinton Cerf ( [1]

Nota-5), un

interesantísimo artículo del propio Vinton Cerf ( [1]

![]() A1.1a), en el que

explica todas estas cuestiones (en ambos casos se ha respetado el original Inglés).

A1.1a), en el que

explica todas estas cuestiones (en ambos casos se ha respetado el original Inglés).

La solución a este problema vino de la mano de la RAND

Corporation (otra agencia de investigación gubernamental que tuvo un papel

destacado en la obtención de la primera bomba atómica). Fue una ampliación

del concepto multiplexación antes aludido, y recibió el nombre de Conmutación

de Paquetes ("Packet-switching" [10] ). La base de la idea consiste en

que la información a transmitir se fracciona en trozos; a continuación se

construye un datagrama o paquete con cada trozo. Además del fragmento de información a transmitir, se añaden

etiquetas con información del origen del que partió, y del destino al que debe llegar [11],

así como otros datos que permiten verificar que el paquete ha llegado íntegro, sin errores de transmisión, y de los diversos

pasos que ha realizado de ordenador en ordenador hasta que alcanza su meta. El camino que tiene que tomar para

alcanzar su destino es indiferente. No importa la ruta, dos paquetes con el mismo origen y destino pueden llegar

por caminos distintos. Gracias a este método, mientras exista algún camino para alcanzar una computadora, esta

permanece comunicada con todos los demás sistemas de la red (esta técnica de comunicación se sigue empleando

actualmente en Internet).

Naturalmente que el sistema exige que los elementos de la red sean lo suficientemente inteligentes para actuar con cada paquete según esa información. Esta "inteligencia" se proporcionó con lo que se denominaba IMP (Interface Message Processors). Una importante característica de diseño es que se contempla la posibilidad de que se "pierdan" algunos paquetes (lleguen mal como consecuencia de fallos y ruido en la transmisión), por lo que el sistema debe poder solicitar el "reenvío" de los trozos perdidos. Además, puesto que según estas premisas y en pura teoría el camino no importaba, los paquetes no deberían llegar necesariamente en el orden correcto, por lo que el receptor debería disponer de un Software suficientemente hábil como para reconstruir en destino el todo original a partir de los trozos desordenados [12].

En 1967 el DoD consideraba las posibilidades del sistema, la agencia ARPA estudia las posibilidades del IMP y empieza a cristalizar la idea de una red que concrete estas elucubraciones teóricas, a las que por esta época comienzan a referirse como "ARPA Contractor Machine-to-Machine Transmission" (lo que luego sería ARPANet).

Para dar respuesta concreta a estas cuestiones y planteamientos teóricos, en 1969 la Agencia ARPA crea ARPANet ("Advanced Research Proyect Agendy Network"), una red experimental de computadoras basada en la tecnología de conmutación de paquetes. ARPANet era un proyecto para interconectar los diversos tipos de redes y permitir el libre intercambio de información entre los usuarios, independientemente de las máquinas o redes que utilizaran. Para ello se agregaron unos equipos especiales, llamados enrutadores o encaminadores, que conectaban redes LAN y WAN de diferentes tipos. Los equipos interconectados necesitaban un protocolo común. El nuevo protocolo de red propuesto por ARPA se denominó NCP [13], y el sistema de esta red de redes interconectadas dio en llamarse Internet (de ahí su nombre).

La primera instalación real de una red de este tipo, se realizó dentro del edificio del Laboratorio Nacional de Física de Inglaterra en 1968. Pronto se construirían modelos mucho mayores. Muy poco después, el Pentágono deseaba construir en USA una red basada en los mismos principios. La tecnología de conmutación de paquetes se convierte rápidamente en la base del programa de redes de datos del Departamento de Defensa y se decide construir una primera red uniendo cuatro ordenadores de alta velocidad (de entonces).

Una compañía de Cambridge ganó el concurso para construir los conmutadores de paquetes IMP que utilizaría la red. En el mes de septiembre llega a la universidad de UCLA el primer IMP (posteriormente esta universidad se convertía en el corazón de la comunidad Internet). Pocas semanas después llegaron IMPs a las universidades de Stanford (Stanford Research Institute, SRI); Santa Bárbara de California (UCSB); Universidad de California en Los Ángeles (UCLA), y la universidad de Utah en Salt Lake City. Cuando estos equipos estuvieron configurados, se conectaron a líneas telefónicas, y ARPANET empezó a funcionar con estos cuatro nodos en 1969.

[0] La crónica de los intentos de construir autómatas y máquinas de cálculo (entre los que hay precursores ingleses y españoles muy notorios) se remonta muy atrás, aunque esta parte de la historia está fuera del objeto de estas páginas.

[1] Winton Cerf es considerado el padre de la Internet.

[2]

John Louis Von Neumann, nacido 28-12-1903 en Budapest, Hungría; fallecido en Washington D.C. el

8-II-1957. Brillante matemático que sintetizó y promovió un concepto súmamente fecundo en el campo de la computación: la idea de un programa que gobierna el funcionamiento de una máquina, almacenado en la propia máquina. Lo que

se ha dado en llamar "Arquitectura von Neumann".

![]() http://ei.cs.vt.edu/

http://ei.cs.vt.edu/

[3] Mark I fue el primer ordenador comercial, se vendieron ocho unidades. Los clientes eran tipos como la Oficina del Censo de los EEUU y sitios semejantes.

[4] Fuera de línea, en contraposición a "On-line", en línea, dos formas de actuar sobre el ordenador, cuando no se tiene una interacción directa e instantánea sobre este o cuando si se dispone de ella respectivamente.

[5] Traducido directamente, "Batch Processing" es Proceso por Lotes.

[6] También conocida como DARPA (Defense Advanced Research Proyects Agency)

[7] Para tener una cabal comprensión del estado actual de la cuestión, no hay que olvidar que el origen de todo esto es iniciativa militar y en USA, las secuelas, aunque muy mitigadas se dejan sentir aún hoy.

[8] Esta técnica se utiliza no solo con los "paquetes" de información de Internet, sino incluso con nuestras propias conversaciones habladas. Se basa en que los equipos que transmiten nuestras conversaciones pueden transmitir un ancho de banda (cantidad de información) muchísimo mayor del que requiere una comunicación de voz, por lo que "meten" trozos de otras conversaciones en el mismo canal. A su llegada los trozos de cada conversación (paquetes) son separados y enviados al interlocutor correspondiente.

[9] Así pues, Internet nace bajo la amenaza del holocausto nuclear, justamente la época de los Beatles y de los Hippies (el poder de las flores).

[10] La idea fue expuesta por primera vez en Julio de 1961 por Leonard Kleinrock del MIT en su "Information Flow in Large Communication Nets". Inicialmente el sistema se denominaba simplemente de "Comunicaciones distribuidas", posteriormente, el británico Donald Davies, del grupo de trabajo de redes del NPL en Scantleburry, Inglaterra, acuñó el término "Packet switching" (Octubre 1967). "The development of packet switching for ARPAnet/Internet. The latter was developed independently, primarily by Larry Roberts and Len Kleinrock. They later learned of Paur Baran's concurrent theoretical studies".

Nota: A la Red se le atribuyen muchas fechas de "cumpleaños", esta de 1961 es una de ellas.

[11] Este paradigma primigenio, un-origen / un-destino, se conoce con el nombre de transmisión "Unicast", frente a otro concepto mas moderno (al que nos referiremos mas tarde), basado en la idea un-origen / múltiples-destinos, denominada "Multicast".

[12] Como veremos mas adelante, son estas características singulares del diseño inicial las que imprimen su carácter especial a las comunicaciones Internet, tanto en pro como en contra. De un lado se consigue de una utilización muy eficiente de la capacidad de transporte de las redes (del ancho de banda) por contra, se trata de un sistema muy poco adecuado para las comunicaciones en tiempo real, por ejemplo telefonía de voz.

[13] NCP "Network Control Protocol". ARPANET empezó usando este protocolo, propuesto por BBN, que ya utilizaba técnicas de conmutación, si bien fue rápidamente reemplazado por el denominado TCP/IP: "Transmission Control Protocol/Internetwork Protocol". El 1 de Enero de 1983 se abandona definitivamente el protocolo NCP, utilizándose exclusivamente TCP/IP que ya había sido aceptado como sustituto oficial del primitivo NCP. Volveremos sobre esto inmediatamente.